Robots.txt is een bestand genaamd waarmee je zoekmachines instructies kunt geven over welke delen van je website wel of niet geïndexeerd mogen worden. Dit kan helpen om de SEO van je website te verbeteren. Ook kan het helpen om onnodige belasting op je server te verminderen.

Stel je voor dat je website een winkel is. Elke bezoeker kan vrij rondlopen, maar soms wil je dat bepaalde secties niet zomaar toegankelijk zijn. Zo werkt het ook met zoekmachines die jouw website doorzoeken. Maar wat is robots.txt precies, en hoe gebruik je het effectief?

Wat is robots.txt nou precies?

Robots.txt is een tekstbestand dat zich bevindt in de hoofdmap van je website. Dit bestand geeft zoekmachines instructies over welke pagina’s of secties ze wel of niet mogen crawlen (doorzoeken en indexeren). Het wordt door zoekmachines gelezen zodra ze je website bezoeken. Door bepaalde pagina’s uit te sluiten, kun je zoekmachines helpen zich te concentreren op de belangrijkste inhoud van je website.

Hoe werkt een robots.txt bestand?

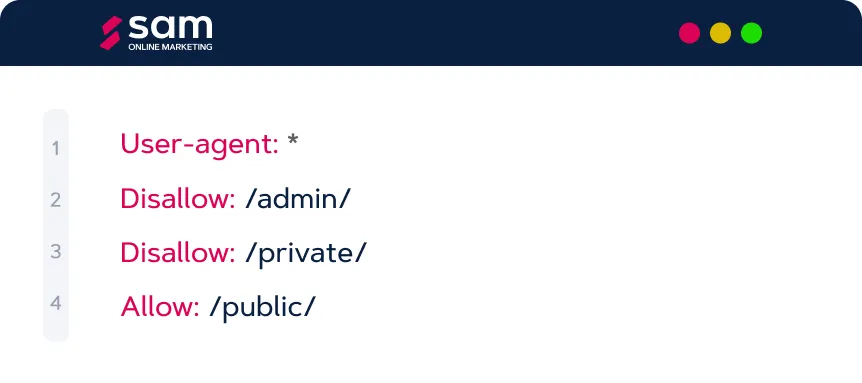

Een robots.txt-bestand is opgebouwd uit regels die de zoekmachines vertellen welke gedeelten van de website toegankelijk zijn. Elke regel in het bestand bestaat uit een User-agent (de zoekmachine die de regels moet volgen) en een Disallow of Allow-regel, die aangeeft of bepaalde URL’s wel of niet mogen worden doorzocht.

Overzicht van de robots.txt onderdelen

Hoewel de meest gebruikte de User-agent, Disallow, Allow en Sitemap, zijn nog een paar andere onderdelen die je kunt gebruiken in een robots.txt-bestand. Hier zijn de robots.txt onderdelen en wat ze doen:

- User-agent: De zoekmachine of webcrawler die de regels volgt (bijv. Googlebot).

- Disallow: Geeft aan welke pagina’s of mappen de crawler niet mag bezoeken.

- Allow: Geeft aan welke specifieke pagina’s wel mogen worden gecrawld. Zelfs als de bovenliggende map is uitgesloten.

- Sitemap: Optioneel. Het is een verwijzing naar de locatie van je sitemap om zoekmachines te helpen je site beter te indexeren.

- Crawl-delay: Hiermee kun je zoekmachines vragen om een vertraging in te stellen tussen het crawlen van pagina’s. Dit is handig als je servercapaciteit beperkt is.

- Host: Wordt gebruikt om zoekmachines te vertellen welke versie van de website ze moeten indexeren. Dit wordt vooral gebruikt in landen waar je meerdere domeinen hebt.

- Noindex: Noindex wordt meestal toegevoegd via de HTML-meta-tag op individuele pagina’s. Zo kun je het ook in een robots.txt-bestand vermelden voor zoekmachines die het ondersteunen. Dit voorkomt dat bepaalde pagina’s worden geïndexeerd.

Een voorbeeld van een robots.txt-bestand

Dit voorbeeld geeft alle zoekmachines (User-agent: *) de instructie om de mappen “/admin/” en “/private/” niet te crawlen, terwijl de map “/public/” wel toegankelijk is.

Waarom is robots.txt belangrijk voor SEO?

Het robots.txt bestand helpt zoekmachines efficiënt door je website te navigeren, en draagt tegelijk bij aan een verbeterde SEO. Hier zijn een aantal manieren waarop het bestand je SEO kan verbeteren:

1. Voorkomen van duplicate content

Soms heb je op je website meerdere pagina’s met dezelfde inhoud. Dit komt bijvoorbeeld voor bij filter pagina’s in webshops. Door deze pagina’s te blokkeren in robots.txt, voorkom je dat zoekmachines deze als dubbele content beschouwen. Dit kan helpen om je ranking te verbeteren.

2. Beperken van onbelangrijke pagina’s

Niet alle pagina’s op je website zijn bedoeld om in zoekresultaten te verschijnen. Denk aan je inlogpagina, winkelwagentje, of interne zoekpagina’s. Door deze pagina’s uit te sluiten in robots.txt, kunnen zoekmachines zich richten op de belangrijkste content, zoals productpagina’s, blogs, en informatiepagina’s.

3. Optimaliseren van crawl budget

Zoekmachines hebben een bepaald crawl budget voor elke website, wat betekent dat ze slechts een beperkt aantal pagina’s binnen een bepaalde tijd crawlen. Door irrelevante pagina’s uit te sluiten in robots.txt, kun je ervoor zorgen dat zoekmachines hun tijd besteden aan het doorzoeken van de belangrijkste pagina’s, wat je SEO kan versterken.

Wanneer gebruik je robots.txt?

Hoewel robots.txt handig is voor het aangeven wat zoekmachines op jouw website mogen doorzoeken, zijn er specifieke gevallen waarin het gebruik ervan echt nuttig is:

- Wanneer je een grote website hebt met veel pagina’s, wil je waarschijnlijk dat zoekmachines alleen de belangrijkste secties doorzoeken.

- Sommige pagina’s zijn bedoeld voor intern gebruik en hoeven niet zichtbaar te zijn in zSoekmachines, zoals beheerders pagina’s of tijdelijke promotie pagina’s.

- Tijdens het ontwikkelen van je website kan het handig zijn om testpagina’s uit te sluiten van zoekmachines.

Wat kan robots.txt niet?

Het is belangrijk om te begrijpen dat robots.txt niet bedoeld is om pagina’s volledig af te schermen van het publiek. Iedereen die de URL van een geblokkeerde pagina weet, kan deze nog steeds bezoeken. Robots.txt is een hulpmiddel om zoekmachines instructies te geven, maar biedt geen beveiliging. Gebruik liever een wachtwoordbeveiliging of andere beveiligingsmethoden voor gevoelige informatie.

Ook is het goed om te weten dat zoekmachines de instructies in robots.txt niet altijd hoeven op te volgen, vooral niet de minder betrouwbare zoekmachines.

Veelgestelde vragen over robots.txt

In het geval je nog vragen hebt over robots.txt, staan hieronder enkele van de veelgestelde vragen. Hopelijk wordt het met deze vragen duidelijker wat robot.txt is en kan.

- Wat gebeurt er als ik geen robots.txt-bestand heb?

Als je geen robots.txt-bestand hebt, gaan zoekmachines ervan uit dat ze je website volledig mogen crawlen. Dit is geen probleem, tenzij je specifieke pagina’s hebt die je liever niet geïndexeerd ziet. - Kunnen zoekmachines geblokkeerde pagina’s vinden via andere links?

Ja, zelfs als je pagina’s blokkeert in robots.txt, kunnen zoekmachines deze pagina’s vinden via externe links. Hoewel ze de inhoud dan niet doorzoeken, kunnen ze de URL toch opnemen in de zoekresultaten. - Is robots.txt hetzelfde als noindex?

Nee, robots.txt blokkeert zoekmachines van het crawlen van een pagina, terwijl noindex een HTML-meta tag is die voorkomt dat een pagina in de zoekresultaten verschijnt, zelfs als hij is doorzocht. - Moet ik alle zoekmachines afzonderlijk blokkeren?

Nee, als je alle zoekmachines hetzelfde wilt aansturen, kun je “User-agent: *” gebruiken om een algemene regel in te stellen.